La historia del desarrollo informático es un tema que a menudo se utiliza para hacer referencia a las diferentes generaciones de dispositivos informáticos. Cada una de las cinco generaciones de ordenadores se caracteriza por un importante desarrollo tecnológico, que cambió fundamentalmente la forma en que funcionan estos dispositivos. La mayoría de los desarrollos principales desde la década de 1940 hasta la actualidad han resultado en dispositivos informáticos cada vez más pequeños, más baratos, más potentes y más eficientes.

Las cinco generaciones de ordenadores, desde 1940 hasta el presente y más allá

Nuestro viaje de las cinco generaciones de ordenadores comienza en 1940 con circuitos de tubos de vacío, y llega hasta nuestros días y más allá, con sistemas y dispositivos de inteligencia artificial (AI).

Primera generación: tubos de vacío (1940-1956)

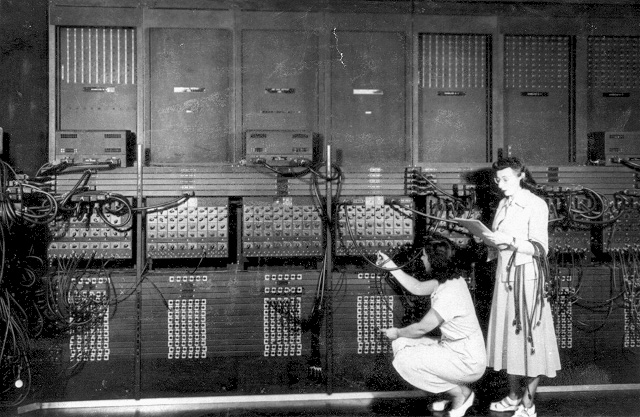

Los primeros sistemas informáticos usaban tubos de vacío para los circuitos y tambores magnéticos para la memoria, estos equipos a menudo eran enormes, ocupando salas enteras. Además eran muy costosos de operar además de utilizar una gran cantidad de electricidad, los primeros ordenadores generaban mucho calor, que a menudo era la causa de un mal funcionamiento.

Los ordenadores de primera generación se basaban en el lenguaje de máquina, el lenguaje de programación de nivel más bajo, para realizar operaciones, y solo podían resolver un problema a la vez. A los operadores les tomaría días o incluso semanas establecer un nuevo problema. La entrada de los datos se basó en tarjetas perforadas y cinta de papel, y la salida se mostró en las impresiones.

UNIVAC y ENIAC son ejemplos de dispositivos informáticos de primera generación. El UNIVAC fue el primer ordenador comercial entregada a un cliente comercial, la Oficina del Censo de los Estados Unidos en 1951.

Segunda generación: transistores (1956-1963)

El mundo vería que los transistores reemplazan los tubos de vacío en la segunda generación de ordenadores. El transistor fue inventado en Bell Labs en 1947, pero no se vio un uso generalizado hasta finales de la década de 1950. El transistor era muy superior al tubo de vacío, lo que permitía que los ordenadores se volvieran más pequeños, más rápidos, más baratos, más eficientes energéticamente y más confiables que sus antecesores de primera generación. Aunque el transistor aún generaba una gran cantidad de calor, fue una gran mejora con respecto al tubo de vacío. Los ordenadores de segunda generación aún dependían de tarjetas perforadas para la entrada y copias impresas para la salida.

Estos equipos pasaron del lenguaje de máquinas binarias crípticas a lenguajes simbólicos o de ensamblaje, lo que permitió a los programadores especificar instrucciones en palabras. Los lenguajes de programación de alto nivel también se estaban desarrollando en este momento, como las primeras versiones de COBOL y FORTRAN. Estos fueron también los primeros ordenadores que almacenaron sus instrucciones en su memoria, que pasaron de un tambor magnético a una tecnología de núcleo magnético. Los primeros ordenadores de esta generación fueron desarrollados para la industria de la energía atómica.

Tercera Generación: Circuitos Integrados (1964-1971)

El desarrollo del circuito integrado fue el sello distintivo de la tercera generación de ordenadores. Los transistores fueron miniaturizados y colocados en chips de silicio, llamados semiconductores, que aumentaron drásticamente la velocidad y la eficiencia.

En lugar de tarjetas perforadas e impresiones, los usuarios interactuaron a través de teclados y monitores, e interactuaron con un sistema operativo, lo que permitió que el dispositivo ejecutara muchas aplicaciones diferentes a la vez con un programa central que monitoreaba la memoria. Por primera vez se hicieron accesibles para una audiencia masiva, porque eran más pequeños y más baratos que sus predecesoras.

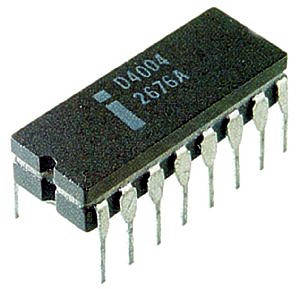

Cuarta generación: microprocesadores (1971-presente)

El microprocesador trajo la cuarta generación de ordenadores, ya que miles de circuitos integrados se construyeron en un solo chip de silicio. Lo que en la primera generación llenaba una habitación entera, ahora cabía en la palma de la mano. El chip Intel 4004, desarrollado en 1971, ubicó todos los componentes, desde la unidad de procesamiento central y la memoria hasta los controles de entrada / salida, en un solo chip.

En 1981, IBM presentó su primer ordenador para el usuario doméstico, y en 1984, Apple presentó el Macintosh. A medida que se volvieron más poderosos, pudieron vincularse entre sí para formar redes, lo que finalmente condujo al desarrollo de Internet. Los ordenadores de cuarta generación también vieron el desarrollo de GUI, el ratón y dispositivos de mano.

Quinta generación: inteligencia artificial (presente y más allá)

Los dispositivos informáticos de quinta generación, basados en inteligencia artificial, aún están en desarrollo, aunque hay algunas aplicaciones, como el reconocimiento de voz, que se están utilizando en la actualidad. El uso de procesamiento paralelo y superconductores está ayudando a hacer realidad la inteligencia artificial. La computación cuántica y la nanotecnología molecular cambiarán radicalmente la cara de las computadoras en los años venideros. El objetivo de la computación de quinta generación es desarrollar dispositivos que respondan al aporte del lenguaje natural y que sean capaces de aprender y autoorganizarse.

No hay comentarios:

Publicar un comentario